Зміст

Q:

Чому штучні рецидивуючі нейронні мережі часто важко дресирувати?

A:

Труднощі навчання штучних рекурентних нейронних мереж пов'язані з їх складністю.

Одним з найпростіших способів пояснити, чому періодично нейронні мережі важко навчати, - це те, що вони не подаються вперед нейронними мережами.

У зворотних нейронних мережах сигнали рухаються лише в один бік. Сигнал переміщується від вхідного шару до різних прихованих шарів і вперед, до вихідного шару системи.

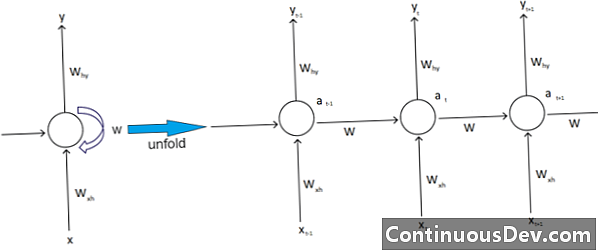

Навпаки, періодичні нейронні мережі та інші різні типи нейронних мереж мають більш складні рухи сигналу. Класифіковані як мережі "зворотного зв'язку", періодично нейронні мережі можуть мати сигнали, що рухаються як вперед, так і назад, і можуть містити різні "петлі" в мережі, де числа або значення подаються назад в мережу. Експерти пов'язують це з аспектом періодичних нейронних мереж, пов'язаних з їх пам'яттю.

Крім того, існує ще один тип складності, що впливає на періодичні нейронні мережі. Один чудовий приклад цього - у галузі обробки природних мов.

У складній обробці природного мови нейронна мережа повинна вміти запам’ятовувати речі. Йому також потрібно брати матеріали. Припустимо, існує програма, яка хоче проаналізувати або передбачити слово в реченні з інших слів. Наприклад, система може оцінити фіксовану довжину в п'ять слів. Це означає, що нейронна мережа повинна мати входи для кожного з цих слів, а також здатність «запам’ятовувати» або тренуватися на зміст цих слів. З тих та інших подібних причин, що повторюються нейронні мережі зазвичай мають ці маленькі приховані петлі та зворотні сигнали в системі.

Експерти нарікають, що ці ускладнення ускладнюють навчання мереж. Один з найпоширеніших способів пояснити це - посилаючись на вибухову і зникаючу градієнтну проблему. По суті, ваги мережі призведуть до вибуху або зникнення значень з великою кількістю проходів.

Піонер нейромережі Джефф Гінтон пояснює це явище в Інтернеті, кажучи, що відсталі лінійні проходи призведуть до зменшення експозиції менших ваг, а великі ваги вибухнуть.

Дана проблема, продовжує він, погіршується довгими послідовностями та більш численними часовими кроками, в яких сигнали ростуть або згасають. Ініціалізація ваги може допомогти, але ці проблеми вбудовані в модель періодичної нейронної мережі. Завжди це буде те питання, яке додається до їх конкретного дизайну та конструкції. По суті, деякі більш складні типи нейронних мереж справді не піддаються нашій здатності легко керувати ними. Ми можемо створити практично нескінченну кількість складності, але часто бачимо, що проблеми передбачуваності та масштабованості зростають.